La elección del tipo de prueba de análisis de resultados a escoger en un TFG va a depender de las características de la muestra y del tipo de tratamiento que se haga con los datos. Por lo tanto, se puede decir que, en función de esta prueba, se va a hacer un tipo de análisis de resultados u otro. Pero el criterio de elección para escoger una prueba u otra es uno de los galimatías más importantes a la hora de elaborar un TFG o un informe científico, sobretodo si se se han ido arrastrando serias dificultades con las asignaturas de investigación a lo largo del Grado. Es importante que sigas leyendo sobre esto si quieres elaborar correctamente el apartado de Método de tu trabajo. Aunque ya las hemos expuesto pormenorizadamente en la entrada dedicada a las pruebas paramétricas y en la de las no paramétricas, podemos recordar las principales diferencias entre ambas.

¿Cuándo usar una prueba paramétrica o una prueba no paramétrica en una investigación?

Que una prueba paramétrica siempre va a ser más potente que una prueba no paramétrica está claro y ha quedado claro en varias ocasiones. Otra cuestión que es importante que sepas es que, independientemente de ese hecho, es cierto también que la eficacia de las pruebas van a aumentar a medida que aumente el tamaño de la muestra. Y con ello, lograremos disminuir la probabilidad de cometer el famoso error de tipo II (esta probabilidad se hace llamar β). A todo esto, resumiendo:

- Una prueba paramétrica es más potente que una no paramétrica.

- Podemos aumentar la potencia de una prueba no paramétrica (y paramétrica) aumentando el tamaño de muestra.

- La probabilidad de cometer un error tipo II (β) o, lo que es lo mismo, concluir erróneamente, con un falso negativo depende de la potencia.

En un estudio de investigación, el error de tipo II, también llamado error de tipo beta (β) (β es la probabilidad de que exista este error) o falso negativo, se comete cuando el investigador no rechaza la hipótesis nula siendo esta falsa en la población.

Lee sobre las diferencias entre los errores tipo I y tipo II.

De todas formas, en la labor de escoger entre una prueba paramétrica o una prueba no paramétrica, interfieren bastantes factores críticos que deberías conocer. Si quieres conocer un paso a paso de las pregunta que todos deberíamos hacernos a la hora de escoger, te invito a que visites la guía que enlazo a continuación:

Las pruebas paramétricas y sus equivalentes no paramétricos

La norma es aplicar una prueba paramétrica siempre que sea posible y, si no se cumplen las condiciones para poder aplicarla, entonces buscar su equivalente no paramétrico. Y es que sí, efectivamente, la mayoría de las pruebas paramétricas tienen sus equivalentes no paramétricas, como si de un metaverso se tratara.

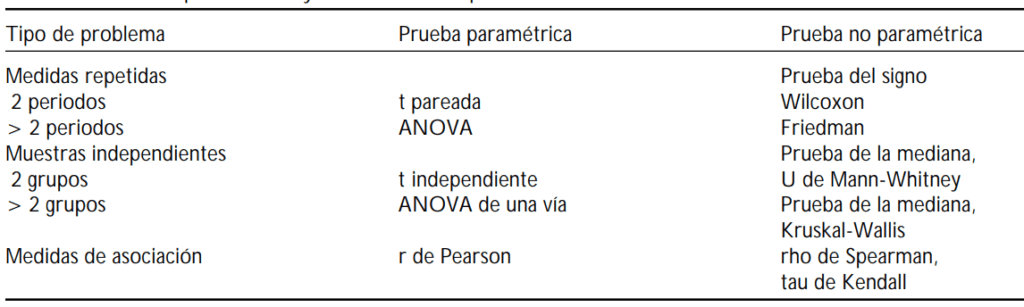

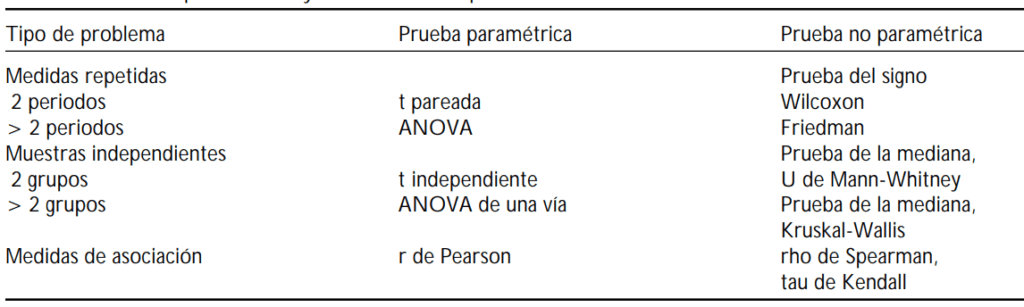

Aun así, en ocasiones no hay equivalentes pero en caso de haberlo, están reflejados en la siguiente tabla:

| ¿Qué necesitamos hacer? | Prueba paramétrica | Prueba no paramétrica |

|---|---|---|

| Comparar una media observada con una teórica | Prueba t para una muestra | Prueba de los rangos con signo de Wilcoxon |

| Comparar dos medias independientes | Prueba t para dos muestras independientes | Prueba de Mann-Whitney |

| Comparar varias medias independientes | ANOVA | Prueba de Kruskal-Wallis/prueba de Mood |

| Comparar dos medias observadas dependientes | Prueba t para dos muestras dependientes | Prueba de Wilcoxon |

| Comparar varias medias observadas dependientes | ANOVA de medidas repetidas, modelos mixtos | Prueba de Friedman / Prueba de Durbin Skilling-Mack, Prueba de Page |

| Probar la asociación entre dos variables cualitativas | Chi-cuadrado sobre tabla de contingencia | Prueba Exacta de Fisher ; método Monte Carlo |

| Probar la asociación entre dos variables cuantitativas | Prueba de correlacion de Pearson | Prueba de correlacion de Spearman |

| Comprobar la existencia de valores atípicos (outliers) | Prueba de Dixon / Prueba de Grubbs | Gráfico de cajas (boxplot ) (no es una prueba) |

En esta tabla se recoge una guía para guiar el criterio de elección entre una prueba estadística adecuada, según el caso. Sobre todo, va a orientar la decisión a partir de la pregunta de investigación y los datos que entren en juego. De manera que se plantea la hipótesis nula y un pequeño ejemplo para cada casuística.

En términos muy generales, podríamos asumir la siguiente regla:

- Si queremos probar las medias de los grupos, haríamos un análisis paramétrico, por lo que necesitaremos seleccionar una prueba paramétrica.

- Si queremos probar las medianas de los grupos, acudiríamos a un análisis no paramétrico, para lo que utilizaremos las pruebas no paramétricas.

La media es la media aritmética de un conjunto de números. La mediana es un valor numérico que separa la mitad superior de un conjunto de la mitad inferior.

Aquí te dejo otra tabla:

Pero existen muchos más criterios que pueden hacer que te decantes por un modelo o por otro. Así que te recomiendo leer las entradas mencionadas para comprender mejor algunos conceptos teóricos básicos al respecto sobre las pruebas paramétricas y las pruebas no paramétricas. Y, después, continuar por aquí.

Todas las pruebas paramétricas y no paramétricas posibles en investigación

La mayoría de las pruebas paramétricas tienen un equivalente no paramétrico para realizar los mismos análisis, independientemente de las distribuciones estadísticas en sus datos. En la tabla de equivalencia que sigue, puedes ver varias pruebas contenidas en nuestro programa.

| Familia | Pregunta | Datos | Hipótesis nula | Ejemplo | Pruebas paramétricas | Condiciones de validez (pruebas paramétricas) | Equivalentes no paramétricas |

|---|---|---|---|---|---|---|---|

| Comparar ubicaciones | Comparar una media observada con una teórica | Medidas en una muestra y 1 media teórica (1 número) | Media observada = media teórica | Comparar una tasa de polución observada con un estándar | Prueba t para una muestra | 2 | Prueba de los rangos con signo de Wilcoxon |

| Comparar dos ubicaciones* observadas (muestras independientes) | Measurements on two samples | Las ubicaciones* son idénticas | Comparar la concentración de hemoglobina entre dos grupos de pacientes | Prueba t dos muestras independientes | 1 ; 2 ; 3 ; 5 | Prueba de Mann-Whitney | |

| Probar la equivalencia entre dos muestras | Medidas sobre dos muestras | Las ubicaciones* son diferentes | Comprobar si el efecto de la medicación A es el mismo que el de la medicación B en la concentración de una molécula en ratones | Prueba de equivalencia (TOST) | 1 ; 2 ; 3 ; 5 | ||

| Comparar varias ubicaciones* observadas (muestras independientes) | Medidas en varias muestras | Las ubicaciones* son idénticas | Comparar rendimientos del maíz de acuerdo con 4 fertilizantes diferentes | ANOVA | 1 ; 3 ; 4 ; 6 | Prueba de Kruskal-Wallis ; Prueba de la mediana de Mood | |

| Comparar dos ubicaciones* observadas (muestras dependientes) | Dos series de medidas cuantitativas sobre las mismas unidades (antes-después...) | Las ubicaciones* son idénticas | Comparar la concentración media de hemoglobina antes y después de un tratamiento se ha aplicado en un grupo de pacientes | Prueba t para dos muestras relacionadas | 10 | Prueba de Wilcoxon | |

| Comparar varias ubicaciones observadas* (muestras dependientes) | Varias series de medidas cuantitativas en las mismas unidades | Las ubicaciones* son idénticas | Seguir la concentración de un elemento de traza en un grupo de plantas a lo largo del tiempo | ANOVA de medidas repetidas , modelos mixtos | 10 ; Sphericity | Prueba de Friedman para diseños de bloques completos; Prueba de Durbin, Skillings-Mack para diseños de bloques incompletos; Prueba de Page para casos en que las puntuaciones de las series se espera que aumenten o disminuyan (a lo largo del tiempo, por ejemplo) | |

| Comparar series de datos binarios | Comparar series de datos binarios (muestras dependientes) | Varias series de medidas binarias sobre las mismas unidades | Las ubicaciones* son idénticas | Un grupo de evaluadores (unidades) valoran la presencia / ausencia de un atributo en un grupo de productos | Prueba de McNemar (para 2 series); Prueba Q de Cochran (para más de 2 series) | ||

| Comparar varianzas | Comparar 2 varianzas (podría usarse para comprobar la asunción 3) | Medidas en dos muestras | varianza(1) = varianza(2) | Comparar la dispersión natural del tamaño en 2 variedades diferentes de una fruta | Prueba de Fisher | ||

| Comparar varias varianzas (podría usarse para comprobar la asunción 3) | Medidas en varias muestras | varianza (1) = varianza (2) = varianza (n) | Comparar la dispersión natural de tamaño en diferentes variedades de una fruta | Prueba de Levene | |||

| Comparar proporciones | Comparar una proporción observada con una teórica | 1 proporción observada con su tamaño de muestra asociado, una proporción teórica | proporción observada = proporción teórica | Comparar la proporción de hembras con una proporción de 0.5 en una muestra | Pruebas para una proporción (chi-cuadrado) | ||

| Comparar entre sí proporciones observadas | Tamaño de la muestra asociado a cada categoría | proporción(1) = proporción (2) = proporción (n) | Comparar las proporciones de los diferentes colores de ojos en una muestra | Chi-cuadrado | |||

| Comparar proporciones observadas con proporciones teóricas | Tamaño de la muestra y proporción teórica asociada a cada categoría | proporciones observadas = proporciones teóricas | Comparar las proporciones de frecuencias de cruzamiento F1xF1 observadas con frecuencias mendelianas (1/2, 1/4, 1/2) | Prueba de Bondad del Ajuste Multinomial | |||

| Pruebas de asociación | Probar la asociación entre dos variables cualitativas | Tabla de contingencia o dos variables cualitativas | variable 1 & variable 2 son independientes | Está la presencia de trazas de un elemento vinculada a la presencia de trazas de otro elemento? | Chi-cuadrado sobre tabla de contingencia | 1 ; 9 | Prueba Exacta de Fisher ; método Monte Carlo |

| Pruebas de asociación entre dos variables cualitativas a través de varios estratos | Varias tablas de contingencia o dos variables cualitativas con un identificador de estrato | variable 1 & variable 2 son independientes | ¿Está la presencia de un elemento de traza vinculada a la presencia de otro elemento de traza? Evaluación sobre distintos sitios (estratos) | Prueba de Cochran-Mantel-Haenszel (CMH) | |||

| Probar la asociación entre dos variables cuantitativas | Medidas de dos variables cuantitativas en la misma muestra | variable 1 & variable 2 son independientes | ¿Cambia la biomasa de las plantas con contenido Pb en el suelo? | Correlación de Pearson | 7 ; 8 | Correlación de Spearman | |

| Probar la asociación entre una variable binaria y otra cuantitativa | Medidas de una variable binaria y otra cuantitativa | Las dos variables son independientes | ¿Está la concentración de una molécula en ratas vinculada al sexo (M/F)? | Correlación Biserial | Normalidad de la variable cuantitativa | ||

| Probar la asociación entre una serie de proporciones y una variable ordinal | Tabla de contingencia o de proporciones y tamaños de las muestras | Las proporciones no cambian de acuerdo con la variable ordinal | ¿Cambian las tasas de nacimiento de las ratas de un año a otro durante la última década? | Prueba de tendencias de Cochran-Armitage | |||

| Probar la asociación entre dos tablas de variables cuantitativas | Dos tablas de variables cuantitativas | Las tablas son independientes | ¿Cambia la evaluación de una serie de productos en una serie de atributos de un panel a otro? | Prueba de coeficiente RV | |||

| Probar la asociación entre dos matrices de proximidad | Dos matrices de proximidad | Las matrices de proximidad son independientes | ¿Está la distancia geográfica entre dos poblaciones correlacionada con la distancia genética? | Prueba de Mantel | |||

| Pruebas de series temporales | Probar la presencia de una tendencia a lo largo del tiempo | Una serie de datos clasificada por fecha (serie temporal) | No existe tendencia a lo largo del tiempo en la variable evaluada | ¿Ha cambiado el precio de almacenamiento en los últimos 10 años? | ¿Ha cambiado el precio de almacenamiento en los últimos 10 años? | Prueba de tendencias de Mann-Kendall | |

| Pruebas sobre distribuciones | Comparar una distribución observada con una teórica | Medidas de una variable cuantitativa en una muestra; parámetros de la distribución teórica | Las distribuciones observadas y teóricas son iguales | ¿Siguen los salarios de una compañía una distribución normal con media = 2500 y desviación estándar = 150? | ¿Siguen los salarios de una compañía una distribución normal con media = 2500 y desviación estándar = 150? | Kolmogorov-Smirnov | |

| Comparar dos distribuciones observadas | Medidas de una variable cuantitativa en dos muestras | Las dos muestras siguen la misma distribución | ¿Es la distribución del peso de las personas la misma en dos zonas geográficas? | Kolmogorov-Smirnov | |||

| Comprobar la normalidad de una serie de medidas (podría usarse para comprobar las asunciones 2, 4 y 7) | Medidas sobre una muestra | La muestra sigue una distribución normal | ¿Es la distribución de la muestra observada significativamente diferente de una distribución normal? | Pruebas de Normalidad | |||

| Prueba de valores atípicos | Comprobar la existencia de valores atípicos (outliers) | Medidas sobre una muestra | La muestra no contiene outliers (siguiendo la distribución normal) | ¿Es el punto de datos un valor atípico (outlier)? | Prueba de Dixon / Prueba de Grubbs | Gráfico de cajas (boxplot ) (no es una prueba estadística) | |

¿Qué métodos no paramétricos existen para el análisis estadístico según el número de muestras?

Se describen las pruebas no paramétricas resaltando su fundamento y las indicaciones para su empleo cuando se trata de una sola muestra (Ji cuadrada, binomial, de rachas, Kolmogorov-Smirnov), de dos muestras con datos independientes (U de MannWhitney, Kolmogorov-Smirnov Moses, o de las rachas de Wald-Wolfowitz), de dos muestras con datos pareados (T de Wilcoxon, del signo, McNemar), de varias muestras con datos independientes (H de Kruskal-Wallis, de la mediana) y de varias muestras con datos pareados (Ji cuadrada de Friedman, W de Kendall, Q de Cochran).

Una sola muestra:

- Ji cuadrada:

- Binomial:

- De rachas:

- Kolmogorov-Smirnov:

Dos muestras con datos independientes:

- U de MannWhitney:

- Kolmogorov-Smirnov Moses:

- De las rachas de Wald-Wolfowitz:

Dos muestras con datos pareados:

- T de Wilcoxon:

- Del signo:

- McNemar:

Varias muestras con datos independientes:

- H de Kruskal-Wallis

- De la mediana

Varias muestras con datos pareados

Hay un artículo de revisión muy interesante con el que puedes profundizar esta información aquí expuesta y que, seguramente, te va a dar muchas pistas sobre cómo elaborar el apartado de Método de tu TFG. Espero que te ayude mucho. Puedes leer el resumen de esta revisión:

Sinopsis de pruebas estadísticas no paramétricas. Cuándo usarlas (Non parametric statistical tests synopsis. When are they used?). Gómez-Gómez, M., Danglot-Banck, C. y Vega-Franco, L. (2003). Revista Mexicana de Pediatría, 70(7), 91-99.

Amplía información sobre este tema: